AppleがWWDC 2017で発表した「iOS 11」は、当日から開発者向けのプレビューが始まり、6月26日から登録したユーザーを対象にしたパブリックプレビュー版が公開された。

バックアップは必須で、メインのデバイスには入れないことをおすすめするが、一般ユーザーも秋にリリースされるiOS 11の機能をいち早く試せる。

iOS 11のインターフェースの刷新については別の記事で触れるが、iOS 11をサポートするアプリがあって初めて実現できる機能も数多く盛り込まれている。拡張現実アプリを実現するARKitや、今回ご紹介する機械学習を活用できるCoreMLもその機能に含まれる。

今回のWWDC 2017でAppleがiOSやmacOSに盛り込んだ新機能を見渡してみると、直近のモバイル向けの最新技術に対して「Appleはどうするんだろう?」という疑問のほぼ全てに答えている。

たとえばVRについては、Metal 2と最新のiMacや外部グラフィックスキットによって、Macでのオーサリング環境を実現している。もちろん、秋に登場する次期iPhoneに、VRに関連する撮影やコンテンツ消費の機能が盛り込まれる可能性も高い。

またARについても、前回の記事で紹介したとおり、ARKitをiOS 11に盛りこみ、ライセンス不要で開発者がARを実装する実装できるようになった。

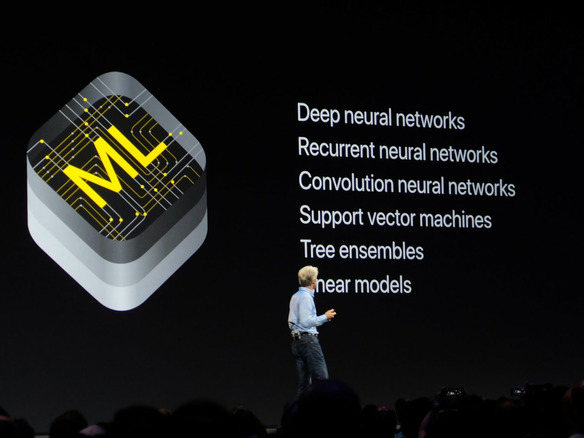

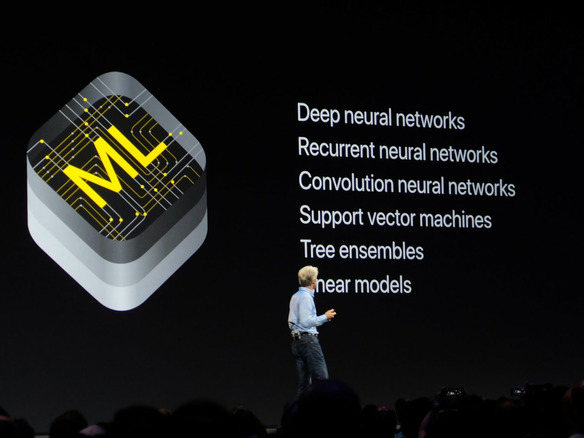

加えて今回のテーマとなっている、機械学習についても、Appleなりの答えをCore MLで出した。Appleの機械学習環境の最大の特徴は、「既存のデバイス」で、「既存の機械学習モデル」を、「オフライン」で実行できる点だ。

CoreMLが動作するのはMac、iPhone、iPad、Apple Watch、Apple TV。ウェアラブルデバイスのApple Watchアプリですら、機械学習モデルを用いたアプリを実行できるようになった。

しかも、各デバイスの中で処理が行われるため、クラウドにデータを投げて処理を返してもらう必要はない。この点は、Appleが強調してきたプライバシーへの配慮を、機械学習の活用にも適用したかたちとなる。

特に明言はしていないが、Apple TVと同じA8プロセッサを搭載するスマートスピーカ、HomePodでも、CoreMLのモデルを活用したプログラムが動作することになるだろう。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

誰でも、かんたん3D空間作成

誰でも、かんたん3D空間作成

企業や自治体、教育機関で再び注目を集める

身近なメタバース活用を実現する

脱炭素のために”家”ができること

脱炭素のために”家”ができること

パナソニックのV2H蓄電システムで創る

エコなのに快適な未来の住宅環境

CES2024で示した未来

CES2024で示した未来

ものづくりの革新と社会課題の解決

ニコンが描く「人と機械が共創する社会」

ビジネスの推進には必須!

ビジネスの推進には必須!

ZDNET×マイクロソフトが贈る特別企画

今、必要な戦略的セキュリティとガバナンス